Sécurité de l’IA Générative : l’ANSSI a publié un guide !

L'Agence nationale de la sécurité des systèmes d'information (ANSSI) a mis en ligne un nouveau guide au sujet de la sécurité de l'IA générative ! Un document probablement attendu par de nombreuses organisations et personnes compte tenu de la popularité du sujet !

Ce guide mis en ligne par l'ANSSI est le bienvenu ! Il devrait donc être consulté par toutes les entreprises qui envisagent d'utiliser ou de concevoir une IA générative.

D'ailleurs, c'est quoi exactement l'IA générative ? L'ANSSI nous propose sa définition dans les premières pages de son guide : "L’IA générative est un sous-ensemble de l’intelligence artificielle, axé sur la création de modèles qui sont entraînés à générer du contenu (texte, images, vidéos, etc.) à partir d’un corpus spécifique de données d’entraînement." - Autrement dit, il s'agit d'une IA destinée à différents cas d'usage tels que les Chatbots, la génération de code informatique ou encore l'analyse et la synthèse d'un document.

L'ANSSI insiste sur le fait que la mise en œuvre d'une IA générative peut se décomposer en trois phases :

1 - La phase d'entraînement, à partir d'ensembles de données spécifiquement sélectionnés.

2 - La phase d'intégration et de déploiement.

3 - La phase de production où l'IA est mise à disposition des utilisateurs.

Chacune de ces phases doit être associée à des "mesures de sécurisations spécifiques", notamment en tenant compte de "la sensibilité des données utilisées à chaque étape et de la criticité du système d’IA dans sa finalité.", peut-on lire. La confidentialité et la protection des données utilisées pour l'entraînement initial de l'IA est l'un des enjeux.

Au-delà de s'intéresser à l'IA générative dans son ensemble, ce guide traite de plusieurs scénarios concrets et qui font échos à certains usages populaires actuels.

Scénarios d'attaques sur un système d'IA générative

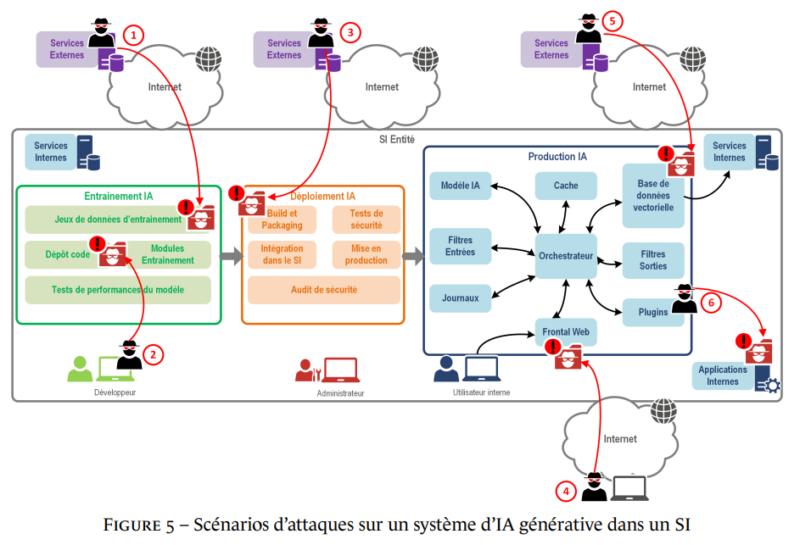

L'ANSSI évoque également des scénarios d'attaques sur l'IA générative, telles que les attaques par manipulation, infection et exfiltration. Le schéma ci-dessous met en lumière plusieurs scénarios où l'attaquant s'est introduit à différents emplacements du SI (accès à l'environnement de développement, accès à une source de données, accès à un plugin sollicité par le système d'IA, etc.).

Sécurité de l'IA générative : les recommandations de l'ANSSI

Tout au long de ce guide, l'ANSSI a introduit des recommandations. Au total, il y a 35 recommandations à mettre en œuvre pour sécuriser l'intégralité d'un système d'IA générative. Il y a un ensemble de recommandations pour chaque phase du déploiement.

L'ANSSI insiste notamment sur l'importance de cloisonner le système d'IA, de journaliser et de filtrer les accès notamment car les plugins externes représentent un risque majeur, et de dédier les composants GPU au système d'IA. Autrement dit, l'ANSSI déconseille de mutualiser le matériel destinée à l'IA.

Pour consulter ce guide, rendez-vous sur le site de l'ANSSI :