Intelligence artificielle et LLM : qu’est-ce qu’une hallucination ?

Sommaire

I. Présentation

Dans cet article, nous allons voir ce qu’est le phénomène d'hallucination dans le domaine de l'IA générative et des LLM (Large Language Model).

Pour rappel, les intelligences artificielles génératives ont pour objectif de créer du contenu à partir des instructions fournies par un utilisateur, qu'il s'agisse de texte, d'images, d'audio ou de vidéos. Les LLM (Large Language Models) sont des IA génératives spécialisées dans la compréhension, le traitement et la production de texte dans une ou plusieurs langues humaines, ainsi que dans certains langages informatiques. Leur capacité à analyser et à générer du langage repose sur des modèles d'apprentissage profond entraînés sur d'immenses volumes de données.

Nous essaierons de comprendre pourquoi une hallucination apparait lorsque l'on utilise une IA générative, comment l’identifier et surtout s’en protéger, car celles-ci peuvent présenter quelques dangers que nous allons étudier.

Le terme “hallucination” est apparu récemment, surtout depuis l’avènement de ChatGPT en version publique et de ses concurrents en 2022. Il faut savoir que la notion d’hallucination appliquée au domaine de l’IA et le phénomène qu’il décrit ne met pas tous les spécialistes d’accord. Nous essaierons ici d’en donner une définition claire pour vous aider à les identifier et à en vous en protéger.

II. IA et hallucination : quelques explications

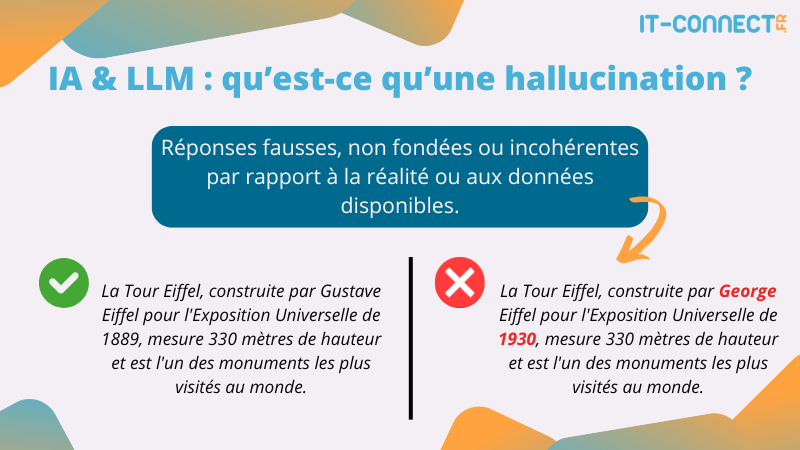

A. Qu'est-ce qu'une hallucination IA ?

Dans le domaine de l'intelligence artificielle générative, une hallucination est un élément généré par le modèle qui est fondamentalement faux, mais présenté de manière convaincante, argumentée et justifiée comme s'il s'agissait d'un élément véridique.

Les hallucinations des IA sont d'autant plus perturbantes qu'elles peuvent apparaitre au milieu d'un texte contenant des données et faits réels et vérifiables. Ainsi, il est souvent particulièrement difficile de les repérer lorsque l'on ne connait pas à l'avance la réponse à la question posée ou lorsqu'il s'agit de domaine complexe dans lesquels l'utilisateur possède des connaissances limitées.

Ces hallucinations peuvent être dans les faits associées à un mensonge. Mis à part un fait important : l’IA générative n’est pas au courant du caractère erroné de son information et celle-ci est présente pour combler un trou dans ses connaissances ou un défaut de conception plus que pour tromper son lecteur.

B. Quelques cas célèbres

Pour illustrer concrètement ce qu’est une hallucination, voyons ensemble quelques cas concrets et célèbres :

Google Bard et le télescope James Webb

Lors de l’annonce du chatbot Bard par Google en 2023, cette IA générative s’est mise à répondre à des questions en argumentant avec des faits manifestement faux. Par exemple, en affirmant que le télescope James Webb avait pris la première photo d’une exoplanète, alors que cette première photo date de 2004 (source), alors que le télescope James Webb a été lancé en 2021.

L’erreur est ici d’autant plus gênante qu’elle apparait dans la publicité de Google lui-même :

Ce cas est en réalité très parlant puisque l’on voit qu’une information erronée est diffusée à la fois par l’intelligence artificielle générative, mais aussi par les équipes de Google elles-mêmes qui ont vraisemblablement fait confiance à la réponse du modèle sans en vérifier l’exactitude avant de faire leur communication.

Source : Theverge.com - Google’s AI chatbot Bard makes factual error in first demo

L'accusation erronée de ChatGPT

ChatGPT d'OpenAI s'est également illustré en matière d'hallucination dans un cas particulier et particulièrement gênant. Le LLM a faussement accusé dans ses réponses un homme politique australien d'être impliqué dans une affaire de corruption alors qu’il en a été le dénonciateur. Cela montre l’impact potentiel d’une telle erreur, puisqu’une telle accusation peut causer des dommages difficiles à réparer sur la réputation d’une personnalité publique, notamment si le lecteur fait une confiance aveugle au modèle IA utilisé.

Sources :

- Reuteurs.com - Australian mayor readies world's first defamation lawsuit over ChatGPT content

- bbc.com - ChatGPT: Mayor starts legal bid over false bribery claim

Ces exemples montrent que même les modèles d'IA les plus avancés peuvent produire des informations totalement erronées ou inventées.

C. Cas concret avec ollama et des IA limitées

Il est en réalité très facile d’observer des hallucinations lorsque l'on utilise une IA générative. Les modèles les plus avancés sont bien sûr moins enclins à halluciner, car leurs concepteurs travaillent à limiter ces “erreurs” et disposent de moyens très importants. Cependant, si l’on utilise des modèles moins avancés, voire des LLM locaux peu entrainé, ces hallucinations arrivent très rapidement.

Pour constater par moi-même ces hallucinations et vous montrer à quoi elles peuvent ressembler, j’ai installé sur mon système via l’outil ollama différents modèles de LLM et leur ai posé quelques questions, voici donc différents exemples de réponses erronées que j’ai pu obtenir.

Les modèles LLM utilisés par ollama sont des modèles open-source que l’on peut installer en local et entrainer. Ces modèles open-source peuvent être modifiés et réentraînés sur des données spécifiques. Il est alors évident qu’ils ne disposent pas des mêmes capacités de calcul et de traitements que les géants comme ChatGPT.

Voici un exemple d’hallucination du modèle llama3.2 (3 milliards de paramètres) :

Pour savoir ce qu’est réellement le paradoxe des jumeaux en physique, je vous oriente simplement vers la page Wikipédia qui le décrit : https://fr.wikipedia.org/wiki/Paradoxe_des_jumeaux

Soyons clair, cette réponse n’a aucun lien avec la réalité, mais ce qui peut paraitre étonnant est que l’ensemble de la réponse semble construite de façon logique et argumentée. Cette réponse ne laisse en rien percevoir le fait qu’elle a été inventée de toute pièce. Encore plus étonnant, je peux poser la même question plusieurs fois de suite, une description très différente du paradoxe me sera donnée à chaque fois avec des arguments et des justifications différents.

Pour mieux comprendre ce que sont les hallucinations, et notamment leurs dangers sur lesquels nous allons nous attarder ensuite, je vous encourage à dialoguer avec des LLM sur des sujets que vous maitrisez parfaitement. Vous vous rendrez probablement compte à un moment que certains points sont faux, mais très bien argumentés et présentés, jusqu’à parfois vous mettre le doute concernant vos propres connaissances.

Nous traitons majoritairement du cas des LLM dans cet article, mais les hallucinations existent aussi dans d’autres catégories d’IA génératives. Nous pouvons notamment citer les IA assistantes de code qui vont se mettre à utiliser des méthodes ou des fonctions qui n’existent pas ou les IA de génération d’images et leurs fameuses mains à 6 doigts.

D. Quelle est la cause des hallucinations des IA génératives ?

Comprendre les causes exactes de l’apparition des hallucinations n’est pas chose facile, même pour leurs concepteurs qui dépensent beaucoup de temps et de ressource pour en diminuer l’occurrence. Il faut commencer par comprendre que les modèles IA utilisent un grand volume de données afin de pouvoir en extraire des tendances récurrentes qui lui serviront à faire des prédictions exactes. Cette phase d’analyse, qui se nomme “entrainement”, peut avoir plusieurs systèmes de supervision (validation des prédictions réalisées lors de l’entrainement) et fait partie intégrante de la conception d’un modèle d’IA générative.

Cet entrainement sert à modeler un réseau de neurones en plusieurs couches qui modifie le poids de la décision accordée par chaque neurone. Ainsi, la demande d’une information par un utilisateur comme la date du dernier record de saut à la perche va trouver réponse grâce au poids des neurones associant les mots de la question posée à la bonne date. Il est important de comprendre que les modèles LLM n’ont pas de “mémoire” (dans le sens base de données), leurs réponses sont systématiquement décidées à la volée en fonction du poids de chaque neurone lors du traitement de notre question.

Lorsque l’on parle des LLM (Large Language Models), un paramètre fait est un élément interne du modèle qui est appris et ajusté lors de la phase d'entraînement. Plus précisément, les paramètres incluent les poids et les biais des différentes couches du réseau de neurones qui compose le modèle. Le nombre de paramètres reflète les capacités d’apprentissage et les performances du modèle.

Dans ce contexte, comprendre la provenance des hallucinations requiert notamment une bonne compréhension du fonctionnement des IA génératives, des réseaux de neurones artificielles en couche, des modèles d’apprentissages et de l’utilisation des probabilités. Nous pouvons quand même tenter de faire un tour d’horizon des principales causes de ces hallucinations :

- Absence de connaissances spécifiques ou contexte limité : les modèles de langage sont entraînés sur de grands ensembles de données, mais ne disposent pas d'une compréhension approfondie ou d'une mémoire spécifique comme un humain. Si une information n'a pas été bien couverte ou qu'elle est absente des données d'entraînement, le modèle peut "halluciner" pour combler ce manque, car il ne disposera pas des bons poids et biais pour y répondre. Il n’aura pas le réflexe d’indiquer qu’il ne connait pas la réponse à la question posée comme le ferait un être humain.

- Données d’entrainement datées ou de faible qualité : les sources de données utilisées dans le cadre de l’entrainement de ces modèles prennent une place très importante. Si ces données sont obsolètes ou contiennent elles-mêmes des erreurs, alors l’IA s’entrainera nécessairement de manière incorrecte, ce qui augmentera les probabilités d’une erreur ou d’une hallucination dans ses générations.

- surapprentissage ou “overfitting” : Il s’agit d’un problème connu issu du Machine Learning qui concerne les cas où l’IA est trop liée à un ensemble de données d’apprentissage et à leurs “bruits” (données inintéressantes). Cela au point de perdre sa capacité à généraliser afin de pouvoir répondre aux contextes qui sortent des données d’apprentissage.

Il existe bien d’autres causes que nous pourrions citer, mais il faut savoir que toutes ne sont pas connues avec exactitude et peuvent avoir des effets très différents en fonction du LLM utilisé ou de la question posée.

III. Les dangers des hallucinations d'IA

Le fait qu'une IA générative puisse halluciner de la sorte présente plusieurs dangers préoccupants, notamment pour les utilisateurs non avertis ou qui utilisent les IA génératives de la mauvaise manière. Nous devons, pour mieux comprendre ces dangers, rappeler quelques-uns des mécanismes de pensée qui sont les nôtres :

- Biais d'autorité et biais de confiance

Les biais d’autorité et de confiance sont une tendance à donner trop d’importance aux avis et informations données par une personne qui exerce une autorité sur nous ou en laquelle nous avons confiance. C’est un biais qui est très présent lorsque nous utilisons l’IA, car celle-ci apparait comme ultra-intelligente et est d’ailleurs présentée comme telle dans la plupart des sites et émissions d’information grand public. Ainsi, ce qu’elle dit nous apparait comme forcément vrai, d’autant plus quand nous sommes nous-mêmes novices dans le domaine de la discussion. Ces biais ont pour effet de grandement diminuer la remise en question des informations fournies.

- Biais de confirmation

Le biais de confirmation est une tendance dans nos mécanismes de pensée qui consiste à donner beaucoup plus de crédits aux arguments et informations qui vont dans notre sens (avis préconçu) et moins aux arguments qui contredisent nos préjugés. Ce biais est d’ordinaire difficile à combattre, d’autant plus quand nous sommes seuls devant un écran et que personne ne vient remettre en question nos idées. Ainsi, les réponses fournies par les IA peuvent être mal interprétées à cause de ce biais de confirmation. Mais aussi, l’IA peut parfois involontairement, en adaptant ses réponses en fonction du contexte ou des formulations, conforter les préjugés ou opinions de l’utilisateur.

En connaissant ces biais, il faut rappeler que certains contextes d'utilisation de l'IA générative peuvent avoir un impact important sur la vie réelle, comme la prise de décision au niveau médical, financier, juridique, ou même au niveau de la gestion de l'humain. En cela, donner une mauvaise information, un mauvais raisonnement ou une fausse donnée peut totalement biaiser les réflexions qui se baseront dessus.

Les impacts des hallucinations d'IA sont en fait très similaires à ceux des fakes news et des campagnes de désinformation : l'implantation de fausses idées et fausses informations dans l'esprit de l'utilisateur. Ces éléments nourrissant ensuite une réflexion qui sera forcément erronée et faussera aussi la compréhension d’un sujet.

Pour être plus précis, il faut aussi savoir faire la distinction entre la désinformation et la mésinformation, qui se différencient dans le caractère intentionnel de la mauvaise information publiée.

Concernant les dangers des hallucinations, nous pourrions en citer d’autres en fonction du point de vue que nous adoptons. Les éditeurs de modèles LLM sont, par exemple, concernés par un risque de fuite et de perte de confiance de leurs utilisateurs envers leurs modèles à cause des hallucinations.

L'IA, bien que puissante, reste un outil imparfait. Les biais cognitifs que nous appliquons à ses réponses peuvent déformer notre compréhension, d'où l'importance de les identifier.

IV. Comment se protéger des hallucinations des IA génératives

Maintenant que nous avons une meilleure idée de ce qu’est une hallucination, nous allons voir quelques bonnes pratiques d’utilisation et éléments de compréhension pour s’en protéger ou utiliser les LLM plus intelligemment.

A. Les bonnes pratiques d'utilisation de l'IA

En tant qu’utilisateur plus ou moins réguliers des intelligences artificielles génératives et LLM, il est possible d’adapter nos usages et approches afin d’éviter ou de réduire les risques posés par leurs hallucinations.

- Vérification des sources : comme pour toute source d’information, il est nécessaire de vérifier les informations fournies par les IA en les recoupant avec d’autres sources fiables (base scientifique, médias vérifiés, etc.). En pratique, cette vérification peut être faite manuellement en recherchant des éléments clés du texte généré. Lorsque l’IA utilisée le permet (comme ChatGPT ou Perplexity), on peut aussi lui demander de citer ses sources. Cela ne garantit pas leur exactitude, mais aide à identifier les fondements de ses réponses.

Nous vous avons présenté Perplexity, une IA qui a pour objectif de réduire ses hallucinations en citant systématiquement les sources de ses informations : Perplexity : le moteur de recherche boosté à l'IA

- Limiter la confiance : il est important de garder un esprit critique envers les informations produites par les LLM, en tenant compte des biais de confiance, d’autorité et de confirmation vus précédemment. La prudence est d’autant plus importante lorsque nous interagissons avec l’IA sur un sujet que nous ne maîtrisons pas, ce qui rend difficile la validation des informations fournies. Par exemple lorsque l’on demande à l’IA d’expliquer ou de synthétiser un sujet complexe.

- Utilisation dans des domaines sensibles : une autre bonne pratique pour mieux se protéger consiste de ne pas utiliser les IA génératives pour des sujets sensibles (juridique, médical, financier, etc.) en raison des conséquences associées aux erreurs potentielles. Plus généralement, il faut toujours garder à l’esprit l’impact potentiel qu’une information erronée générée par l’IA pourrait avoir sur notre compréhension ou prise de décision.

- Utiliser des IA spécialisées : pour certaines questions précises, il peut être préférable d’utiliser des IA ou des sources spécialisées qui offrent des garanties de fiabilité plus élevées qu’un LLM généraliste. On peut notamment mentionner le modèle RAG (Retrieval-augmented generation) dans lequel l’IA est alimentée avec des données “métiers” ou spécifiques à un contexte et sera en possibilité de rechercher dans ces données pour fournir une information. Cette approche peut aider, mais qu’elle ne remplace pas une vraie expertise.

- Combiner les avis de plusieurs LLM : une autre approche consiste à poser la même question à plusieurs LLM différents et à comparer leurs réponses. Si plusieurs modèles aboutissent à des réponses similaires, cela peut renforcer la crédibilité des informations, bien que cela ne remplace pas une validation par des sources fiables. Une astuce que j’utilise aussi de temps en temps consiste à faire vérifier la réponse d’un LLM par un autre.

Voici une infographie qui résume ces points :

Les grands éditeurs d’IA génératives telles que OpenAI ou Google sont conscients du problème des hallucinations de leurs IA génératives. Ainsi, ceux-ci déploient de grands moyens pour limiter leurs apparitions. Il faut cependant garder en tête que les hallucinations peuvent aussi être une “fonctionnalité” recherchée par certains utilisateurs. Par exemple, lorsque l’on souhaite créer des histoires fictives, imaginaires ou les utiliser comme source d’inspiration.

B. Un peu de recul

Le danger des hallucinations repose surtout sur la différence entre ce que la majorité des utilisateurs attendent des IA génératives et la façon dont elles sont construites. Dans leur grande majorité, et dans la tendance actuelle initiée par la publication de ChatGPT en 2022, les IA génératives ont pour fonction première de générer du contenu textuel en se basant sur les probabilités d'apparition d'un mot à la suite d'un autre. En cela, ChatGPT et ses semblables n'ont aucune conscience du sens du texte qu'ils ont en train de saisir et encore moins du caractère véridique de celui-ci.

Pour les plus curieux, je vous encourage à aller plus loin dans votre compréhension de la conception et du fonctionnement des IA génératives. Passer quelques heures à creuser le sujet fait apparaitre de façon évidente le fait que les hallucinations sont une conséquence logique du fonctionnement des IA génératives et LLM.

Lorsque l'on utilise une IA générative telle que ChatGPT en tant qu'utilisateur non averti, nous nous attendons à discuter avec un être intelligent doté d'une grande mémoire et capable de nous transmettre ses idées et connaissances de manière illimitée. En cela, la production ultra-rapide d'un texte correctement écrit et la proposition d'une réponse à toutes les questions qui sont posées apparait comme une preuve de grande intelligence.

Cependant, ces deux éléments n'ont rien à voir l'un avec l'autre. Les IA génératives sont en fait pleinement dans leur rôle de production de contenu logiquement construit (d'après leur probabilité) alors qu'un utilisateur qui cherchera à avoir une information véridique et cohérente pourrait être surpris. C'est cette différence d'attente entre l'IA générative et l'utilisateur qui mène à cette notion d'hallucination. Le problème se situe peut-être en fait de notre côté, utilisateurs, qui nous attendons à ce qu'une "intelligence", toute artificielle qu'elle soit, soit capable de réfléchir et de mémoriser à notre place.

Si l'on sort un peu du domaine technique, le cerveau humain hallucine tout autant qu'une intelligence artificielle, ne vous est-il jamais arrivé de vous souvenir avec certitude de quelque chose qui s'est ensuite avéré être totalement faux ?

Parmi la quantité incroyable de données, textes et informations que les IA sont capables de générer, il y a bien une phrase qu’elles semblent incapables d’écrire : je ne sais pas.

V. Conclusion

Nous avons dans cet article traité du sujet des hallucinations dans le domaine des intelligences artificielles génératives et LLM. Il y aurait encore beaucoup à dire sur ce sujet brulant qui semble difficile à résoudre complètement. Expliquer le pourquoi de l’apparition d’une hallucination au sein d’un modèle est également un sujet complexe qui requiert de bonnes connaissances à propos de la manière dont ces modèles sont conçus et entrainés.

Le plus important en tant qu’utilisateur régulier et non expérimenté de ces IA est de savoir que ces hallucinations existent, de connaitre leurs impacts et dangers, mais aussi quelques astuces et outils pour s’en protéger ou réduire leurs risques.

Si vous avez, vous aussi, été concerné par des hallucinations d’IA génératives qui ont eu un impact important ou que vous avez d’autres techniques en tête pour réduire ce risque, n’hésitez pas à nous les partager dans les commentaires ou sur notre serveur Discord.