Crawlers ? Spiders ? Robots ? C’est quoi ça ?

Apprenons à faire connaissance avec les crawlers, spiders, robots ou encore les bots. Ces éléments indispensables au bon fonctionnement d’un moteur de recherche et à l’indexation de vos contenus. Parmi les plus connus et ceux que vous devez voir passer sur votre site nous pouvons citer « Googlebot » de Google et « BingBot » de Bing.

C’est quoi ?

N’ayez pas peur de ces termes, il n’est pas question de natation, ni de Spider Man. Quoi que, il est bien question ici de navigation, de tisser la toile du web.

En fait, crawlers, spiders, agents, bots ou encore robots sont des termes qui signifient tous la même chose. Ce sont des programmes de navigation qui parcoure en permanence les pages web et leurs contenus afin d’indexer le contenu.

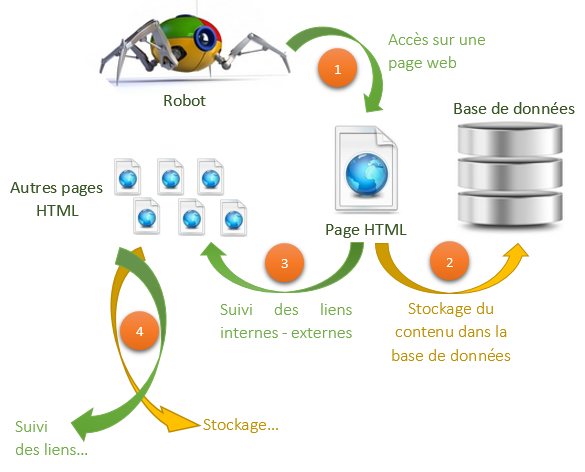

Pour cela, ils suivent les liens intégrés dans une page et reviennent périodiquement afin de prendre en compte les nouveaux contenus – s’il y en a eu – ou une éventuelle modification dans un contenu.

Un robot sait faire deux choses :

Comprenez bien que ces robots n’ont pas le temps de s’ennuyer... Le web est tellement actif, de nouveaux liens se créent continuellement, du nouveau contenu est sans cesse ajouté sur un site ou sur un autre. Autrement dit, ces robots parcourent le web 24h/24 afin d’être le plus efficace possible et d’indexer au plus vite le contenu découvert.

Le robot est l’élément essentiel qui collecte l’information pour le moteur de recherche.

Comment fonctionne un robot ?

Voici un schéma qui reprend globalement le fonctionnement de la collecte d’information effectuée par un robot :

Attention toutefois, le fonctionnement d’un moteur de recherche ne s’arrête pas à celui du crawler. Nous aborderons le fonctionnement de façon plus détaillée dans un prochain article.

En parlant de bots, je ne sais pas si vous avez eu l’occasion de jouer un peu avec scrapebox mais c’est un outil multitâches très sympathique et relativement puissant pour son prix.